¿Es la IA un hype? Noam Chomsky y el ‘lenguaje imposible’ de Elon Musk

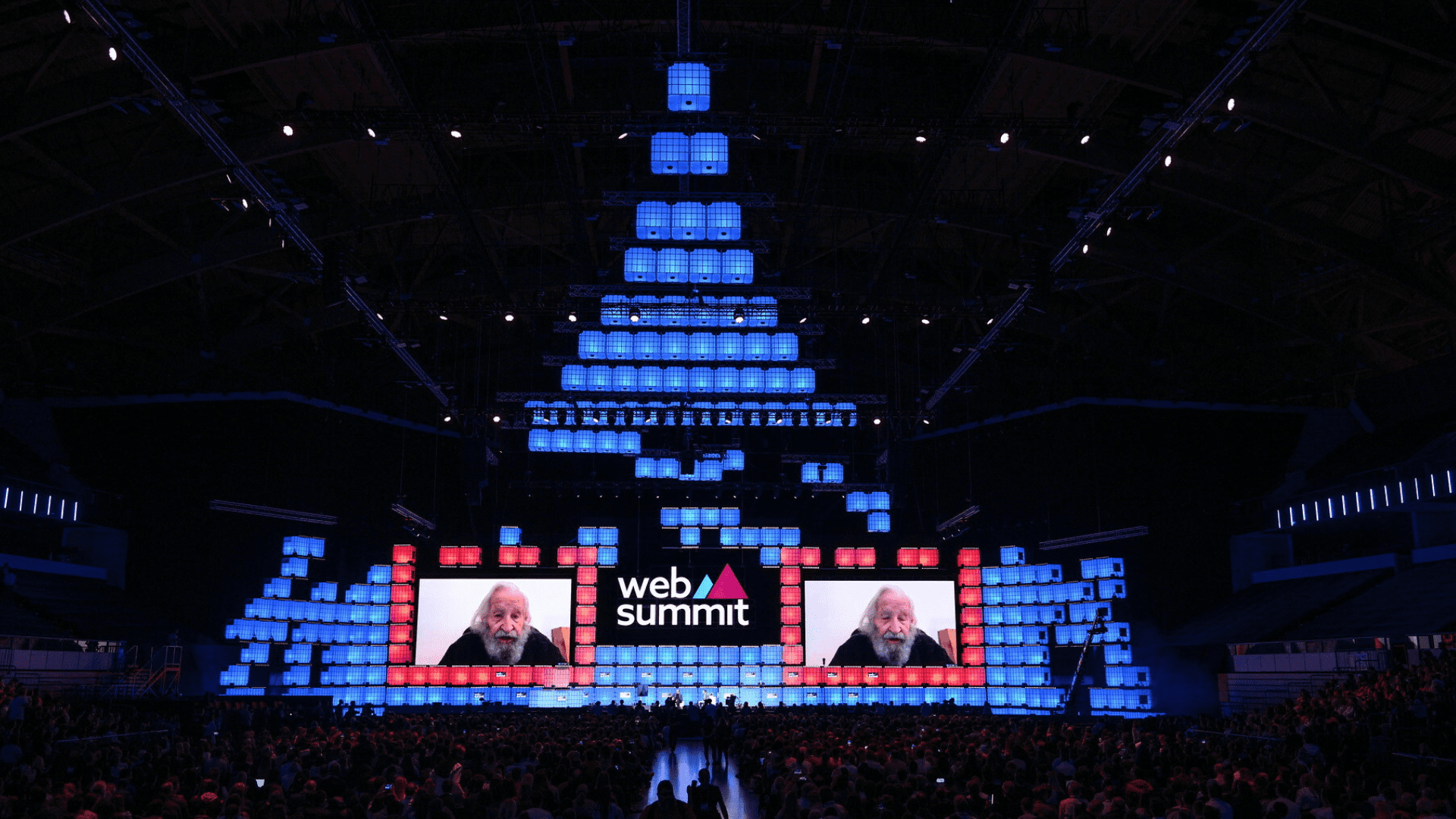

La intervención en el Web Summit de Noam Chomsky, padre de la lingüística moderna y profesor del MIT, lleva un título elocuente: “Desacreditando la mentira de la IA”. Tanto sus dardos como los del investigador de la Universidad de Nueva York, Gary Marcus, que refuerza sus mensajes desde el escenario, se dirigen a los dos grandes modelos surgidos de los fogones de OpenAI, uno de cuyos fundadores es Elon Musk: el sistema de generación de textos GPT-3 y el de imágenes DALL-E.

“Se han encontrado motivos por los que GPT-3 es deficiente”, dice Chomsky. “Este sistema y otros no hacen ciertas cosas. Creemos que podemos resolverlo porque contamos con millones de programadores, pero cuando un sistema es demasiado fuerte, es irreparable y ese es el problema. Si le entregas una base de datos al GPT-3, se convierte en un lenguaje imposible al violar las leyes del lenguaje. Aunque pueda hacerlo bien, a menudo mejor, porque las reglas son mucho más sencillas”.

Una de las propiedades fundamentales con las que el lenguaje funciona, explica, es que “las reglas clave no ignoran lo que compone a las palabras”. Frente a ello, “es muy fácil construir lenguajes imposibles que usan procedimientos muy simples e incluyen un orden lineal de palabras, pero eso no es un lenguaje”.

Su sentencia es que “si un sistema funciona igual de bien para lenguajes imposibles que para uno posible, por definición no nos está diciendo nada acerca del lenguaje, y así es la forma en la que funcionan estos sistemas”.

Gary Marcus incide en que “una de las aportaciones de los lenguajes es que ponemos en relación significados que pertenecen a diferentes órdenes del mundo, y estos sistemas no entienden esa relación y los significados subyacentes. El trabajo de Noam ha sido entender por qué el lenguaje humano es como es, estos sistemas no nos dicen nada acerca de por qué somos las criaturas especiales que somos”.

La separación entre ingeniería y ciencia, un asunto no exento de controversia, pasa a centrar el discurso de Chomsky. “Los logros de ingeniería pueden contribuir a la ciencia, como el telescopio”, y bromea con que ha podido seguir la conversación de sus interlocutores gracias a un sistema de transcripción automática. “Hay aparentemente logros de ingeniería en los enfoques del Deep learning que son similares al telescopio y producen resultados que ayudan en ámbitos como el plegamiento de proteínas, gracias a la computación masiva que hay detrás”.

Pero su tesis es que “la ciencia tiene preocupaciones distintas, intenta comprender cómo es el mundo, no cómo puedo hacer algo útil. No hay nada malo en hacer cosas útiles. Pero el proyecto que trata de entender cómo es el mundo es diferente. Si el sistema no distingue el mundo natural del no natural, no está diciéndonos nada. Sistemas como GPT-3 pueden detectar con precisión regularidades, manejar astronómicas cantidades de datos y producir algo que parezca inteligente, pero puede hacer exactamente lo mismo, e incluso mejor a menudo, con datos que violan todos los principios del lenguaje y la misión del código, de modo que no nos enseñan nada acerca de ello”.

“Te puedes preguntar si tienes una contribución de ingeniería, y en este caso he visto muchas, como las de GPT-3, aunque quizás acabe usándose para falsear exámenes”, dice el investigador. “Pero no hay una contribución científica, lo que veo es básicamente una forma de gastar un montón de energía en California”.

Para Gary Marcus uno de los peligros es que “estamos haciendo algo que está muy bien, pero no es tan profundo como necesitamos”, y ese esfuerzo “está extrayendo el oxígeno de la parte en la que debe intervenir la ciencia”. Es “muy divertido” jugar con “esos juguetes. Los jóvenes graduados, cuando tienen que elegir entre trabajar en lingüística o en GPT-3, donde les pagan un montón de dinero, elegirán esto último, pero es algo corto de vista. La IA es superpopular por un momento y necesitamos algo que sea más estable”.

Otro riesgo es que “los sistemas que tenemos ahora, lo único que hacen es perpetuamente pasar datos, no entienden el mundo. Pueden ser sexistas o racistas y no se trata de hayan sido construidos así, sino de que copian datos producidos de ese modo. Pueden estar mintiendo continuamente, sin mala intención ni maldad, y producir desinformación de una forma enorme. El coste que eso puede tener es realmente devastador para las democracias”.

“En 2023 predigo que se producirá una muerte atribuible a uno de estos sistemas”, afirma GARY Marcus. “La gente confía en estas cosas porque es una especie de magia. Yo tengo aversión al autocompletado, cuando el móvil predice la siguiente palabra. El GPT-3 es un autocompletado con esteroides. Lo veremos muy presente el próximo año porque estos sistemas se distribuirán ampliamente y serán baratos”.

“No puedo pensar en una solacosa en la que estos sistemas contribuyan a la lingüística”, apostilla Chomsky. “El objetivo original de la IA fue utilizar las capacidades que se habían desarrollado en la ciencia de la computación, técnicas y teóricas, como las teorías de Turing y otros, para entender cómo piensan los humanos. Es famoso el paper de Alan Turing de 1950 titulado “¿Pueden las máquinas pensar?”. Él estaba interesado en entender qué significa pensar y otros pioneros en ese campo trabajaron en lo que podemos saber acerca de la codificación del pensamiento”.

“Todo este trabajo ha sido valientemente reemplazado a lo largo de los años por esos juguetes de lujo. Cuando llegué al MIT en los 50 una de las formas de divertirse de los estudiantes era jugar con trenes electrónicos muy elaborados. En los 60, los trenes eléctricos ya no eran divertidos, buscaban otras cosas como programar los ascensores. Es lo que sucede con el sistema de transcripción, es útil, pero no contribuye a entender el mundo”, dice.

“¿Alguna vez han tomado alguna clase de lingüística?”, se pregunta Marcus. “Ahí aprendes la relación entre sintaxis u semántica. La gente puede creer que no necesita comprender el significado porque dispone de un montón de datos, pero eso no es cierto, aún necesitas hacerlo”.

Eugenio Mallol

Eugenio Mallol