Los algoritmos cuánticos se consolidan ya en la caja de herramientas de la industria para liderar la ola del 2030

Una carrera tecnológica valorada en aproximadamente 40.000 millones de dólares comienza a acelerar. Según el reciente informe de McKinsey and Company, la computación cuántica abandona el laboratorio y comienza a introducirse en la planta industrial con promesas de ahorros operativos de doble dígito antes de 2030. De este modo, las empresas deben levantar las orejas para atender al nuevo paradigma: se ha abierto una ventana para experimentar con algoritmos híbridos y construir equipos capaces de convertir una tecnología todavía inmadura en futuras ganancias, eficiencia y aceleración I+D. Por tanto, quien dé estos primeros pasos ahora, llegará a la próxima década con una cuerva de aprendizaje que se mesura en beneficios.

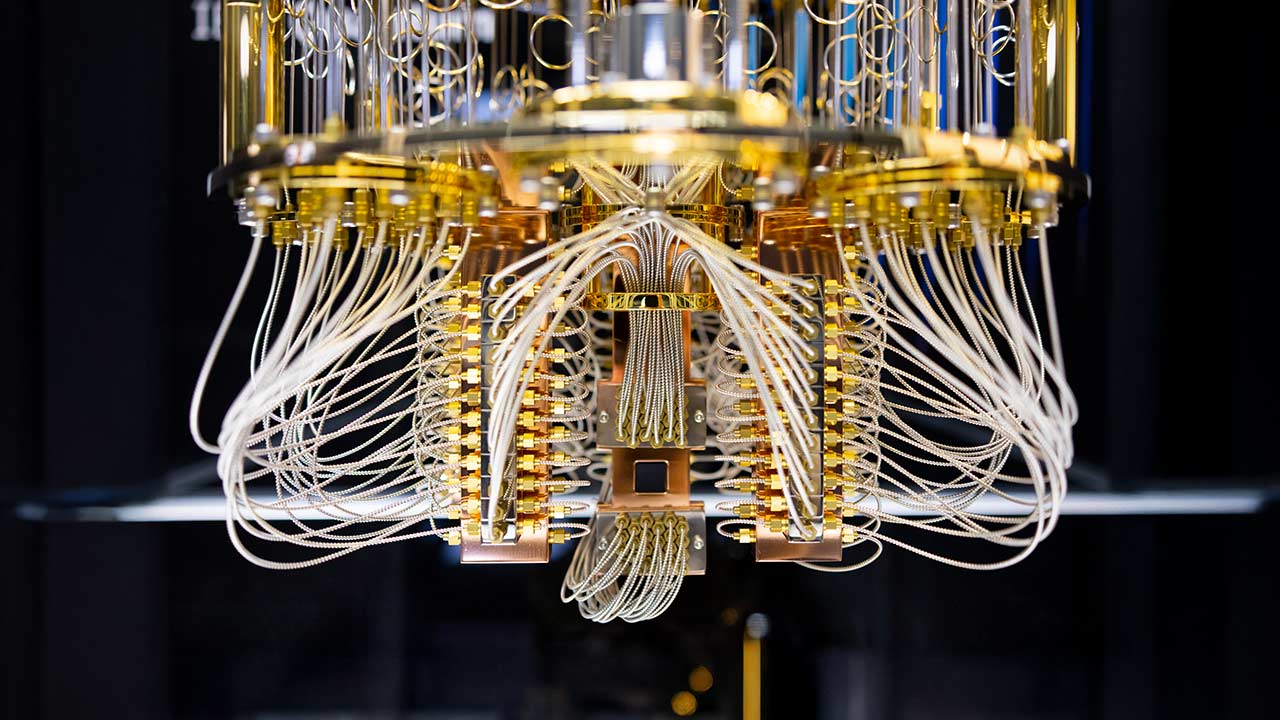

La lógica del negocio se articula de forma que se aprovechen al máximo las llamadas «ventanas cuánticas». Este término hace referencia a aquellos momentos concretos en los que un pequeño chip cuántico, que trabaja conjuntamente con un ordenador cuántico, demuestra las ventajas que puede ofrecer frente al uso exclusivo de un software tradicional. Para poder extraer la máxima eficiencia de esta colaboración entre lo clásico y lo cuántico, y encontrar la solución óptima al caso, se emplean algoritmos híbridos. Esta herramienta se encarga, en esencia, de «repartir las tareas» entre el sistema clásico y el procesador cuántico. Por una parte, el chip cuántico se ocupa de explorar combinaciones complejas y devolver resultados medidos, mentiras que el ordenador clásico analiza esos resultados, ajusta los parámetros del sistema y vuelve a lanzar el cálculo. Este proceso se repite varias veces hasta que se encuentra una solución, y suele ser más rápido que si se usara solamente un enfoque clásico.

En logística y cadena de suministro los pilotos más avanzados exploran un modelo de trazabilidad dinámica, consolidación de cargas y planificación de inventarios sobre gemelos digitales capaces de simular millones de combinaciones. McKinsey revela que con la cuántica se han registrado reducciones de entre el 5% y el 12% en kilómetros recorridos y hasta un 8% en capital inmovilizado, cifras que se traducen en menores emisiones y mayor resiliencia ante disrupciones geopolíticas o climáticas.

Mientras tanto, la industria manufacturera observa otra palanca: mantenimiento predictivo reforzado por la cuántica, que detecta patrones débiles en señales de vibración, temperatura o ultrasonidos. Los primeros casos internos reflejan caídas de hasta el 20% en paradas no planificadas y descensos del 15% en coste de repuestos, extendiendo la vida útil de los activos y liberando capacidad productiva sin inversiones adicionales.

Nuevas necesidades para nuevos horizontes

No obstante, para que esos resultados funcionen parece necesaria una «capa» de software que integre el uso de ordenadores ordenadores cuánticos dentro del flujo normal de trabajo de los desarrolladores. Es decir, que se escondan las diferencias entre los diferentes tipos de dispositivos cuánticos, como superconductores, iones atrapados, átomos neutros o fotónica.

En concreto, McKinsey afirma que esta forma de trabajar puede acelerar los experimentos alrededor de un 30% porque convierte la experimentación cuántica en un proceso repetible y medible, además de que da más banda ancha a fallar y corregir más rápido. Sobre esa base aparecen productos listos para usar: servicios de optimización logística en la nube, herramientas de detección de anomalías integrables vía API o soluciones de seguridad que preparan a las empresas para un futuro en el que los ordenadores cuánticos puedan romper cifrados actuales.

La captura sostenida de valor no es solo tecnológica, sino organizativa. McKinsey subraya que las compañías líderes están configurando equipos interdisciplinarios donde físicos y matemáticos diseñan algoritmos, ingenieros de datos y arquitectos cloud se encargan de la integración continua, y expertos de negocio traducen métricas cuánticas en indicadores comprensibles para comités de inversión. Es decir, conceptos como profundidad de circuito, número efectivo de qubits se traduce a reducción de emisiones, aceleración de I+D o mitigación de riesgo financiero.

Con la mirada clavada en el horizonte del 2030, el objetivo reside en corregir errores para permitir la integración progresiva de qubits lógicos, que posibilitarán la mejoría de la computación cuántica. Actualmente, los chips cuánticos cometen múltiples errores y no aguantan cálculos largos. La clave, en este marco, es juntar los qubits físicos (menos funcionales) con qubits lógicos (más estables) para reducir la tasa de fallo. Con este logro, será posible ejecutar programas mucho más largos y complejos y, con ello, una nueva generación de algoritmos de simulación y optimización que ahora no cabe lugar porque el hardware se estropea antes de terminar.

Si las trayectorias actuales se mantienen, los sectores que hayan comenzado ahora pilotos, aunque sea con pruebas pequeñas, encabezarán la carrera para posicionarse cuando llegue el momento en el que la tecnología madure completamente; aproximadamente en 2035. Para ingenieros y directores de innovación el mensaje es inequívoco: la computación cuántica no sustituirá de inmediato al stack clásico, pero sí se perfila como una extensión estratégica cuya curva de aprendizaje comienza hoy y cuya inercia competitiva puede resultar decisiva mañana.

Carla Mansanet

Carla Mansanet